はじめに

自然言語処理の分野で、N-gramは非常に重要な役割を果たしています。テキストデータを分析する際、単語の並びや出現頻度を考慮することで、より精度の高い結果を得ることができるのです。本記事では、N-gramの基本概念から応用例まで、わかりやすく解説していきます。

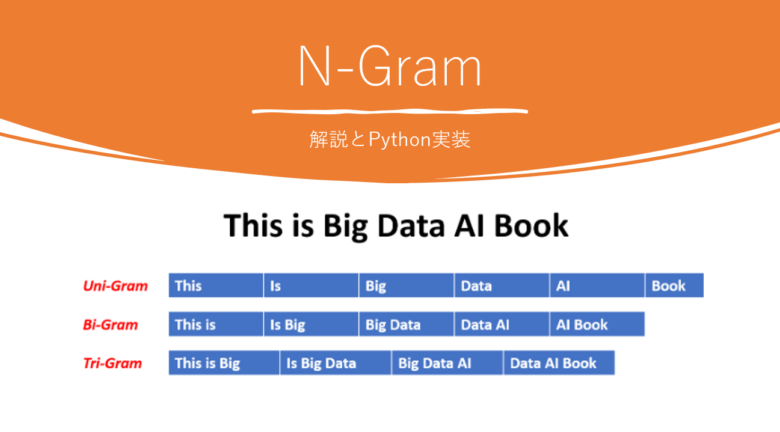

N-gramとは?

N-gramとは、テキストデータを連続したN個の要素(単語や文字)に分割する方法です。例えば、「私は自然言語処理が好きです」という文を、単語単位で2-gram(バイグラム)に分割すると、「私は」「は自然」「自然言語」「言語処理」「処理が」「が好き」「好きです」となります。

N-gramの数式表現

N-gramの確率は、以下の数式で表現できます。

$$P(w_1, w_2, …, w_n) = P(w_1) \times P(w_2|w_1) \times … \times P(w_n|w_1, w_2, …, w_{n-1})$$

N-gramの種類

ユニグラム

ユニグラム(1-gram)は、テキストを単語や文字単位で分割し、それぞれの出現頻度を数えます。例えば、「私は自然言語処理が好きです」というテキストのユニグラムは、「私」「は」「自然」「言語」「処理」「が」「好き」「です」となります。

バイグラム

バイグラム(2-gram)は、連続する2つの単語や文字をペアとして扱います。先ほどの例で示したように、「私は自然言語処理が好きです」を単語単位でバイグラムに分割すると、「私は」「は自然」「自然言語」「言語処理」「処理が」「が好き」「好きです」となります。

トライグラム

トライグラム(3-gram)は、連続する3つの単語や文字を組み合わせて扱います。「私は自然言語処理が好きです」を単語単位でトライグラムに分割すると、「私は自然」「は自然言語」「自然言語処理」「言語処理が」「処理が好き」「が好きです」となります。

N-gramの応用例

言語モデル

N-gramは言語モデルの構築に広く使用されています。言語モデルは、テキストデータの確率分布を学習し、新しい文章の生成や次の単語の予測に役立ちます。N-gramベースの言語モデルは、直前のN-1個の単語を考慮して次の単語の確率を計算します。

文章の類似度計算

N-gramを用いて、2つの文章がどの程度似ているかを計算することができます。これは、文章の分類やクラスタリングに有用です。具体的には、2つの文章から抽出したN-gramの重なりを比較することで、類似度を算出します。

スペルチェック

N-gramは、スペルチェックにも活用されています。単語のN-gramを用いることで、スペルミスを検出し、正しい単語を推測することができます。例えば、「言語処理」というバイグラムが高頻度で出現する一方、「言語処裡」というバイグラムの出現頻度が低い場合、「処裡」がスペルミスである可能性が高いと判断できます。

N-gramのメリットとデメリット

メリット

- シンプルで直感的

N-gramは、テキストデータを連続したN個の要素に分割するという非常にシンプルな手法です。この直感的な概念のおかげで、初学者でも理解しやすく、様々な自然言語処理タスクに応用することができます。 - 計算が高速

N-gramの計算は、テキストデータを走査し、N個の要素を抽出するだけなので、非常に高速に処理できます。大量のテキストデータを扱う際にも、効率的に計算を行うことができるでしょう。 - 言語に依存しない

N-gramは、言語に依存しない手法です。つまり、日本語、英語、中国語など、様々な言語のテキストデータに対して適用することができます。この特性により、多言語対応のシステムを構築する際にも役立ちます

デメリット

- 長距離の依存関係を捉えることが難しい

N-gramは、近接するN個の要素のみを考慮するため、長距離の依存関係を捉えることが難しいという欠点があります。例えば、「私は昨日、図書館で借りた本を読んだ」という文において、「借りた」と「本」の関係を捉えるには、バイグラムやトライグラムでは不十分です。 - データスパースネス問題

N-gramでは、Nが大きくなるにつれて、出現頻度の低いN-gramが増加します。これにより、データスパースネス問題が生じる可能性があります。つまり、訓練データに出現しないN-gramが、テストデータに多数出現する可能性があり、モデルの汎化性能が低下するリスクがあります。

Pythonで実装してみた

from collections import defaultdict

def generate_ngrams(text, n):

words = text.split()

ngrams = zip(*[words[i:] for i in range(n)])

return [" ".join(ngram) for ngram in ngrams]

def calculate_ngram_frequency(text, n):

ngrams = generate_ngrams(text, n)

freq_dict = defaultdict(int)

for ngram in ngrams:

freq_dict[ngram] += 1

return freq_dict

# 使用例

text = "私は自然言語処理が好きです"

print("バイグラム:", generate_ngrams(text, 2))

print("バイグラム頻度:", calculate_ngram_frequency(text, 2))まとめ

本記事では、自然言語処理におけるN-gramの重要性について解説しました。N-gramは、テキストデータを連続したN個の要素に分割する手法であり、言語モデルの構築、文章の類似度計算、スペルチェックなど、様々な場面で活用されています。N-gramの基本概念を理解し、適切に応用することで、自然言語処理のタスクにおいてより良い結果を得ることができるでしょう。

コメント