はじめに

大規模言語モデル(LLM)の開発コストが高騰する中、モデルマージングという新しい技術が注目を集めています。モデルマージングは、複数の事前学習済みモデルを組み合わせることで、低コストでLLMを開発する画期的なアプローチです。しかし、現状のモデルマージングは人間の直感とドメイン知識に大きく依存しており、自動化が難しいという課題があります。

本記事では、この課題を解決するSakana AIが提唱した新手法「Evolutionary Model Merge」を紹介します。Evolutionary Model Mergeは、進化的アルゴリズムを用いてモデルマージングを自動化する革新的な技術です。日本語数学LLMと日本語VLMの開発事例を通じて、その有効性を実証します。また、進化的モデルマージの将来性と展望についても議論します。

sakana-AIとは

元Google AIの研究者であるLlion Jones氏とDavid Ha氏によって2023年8月に設立されたスタートアップです。

Jones氏は、生成AI革命のきっかけとなった論文「Attention Is All You Need」の8人の著者の1人。Attentionは今の生成AIの基礎になっているといっても過言ではない技術です。

Ha氏はGoogle BrainやStability AIの研究トップを経た、とんでもない技術者です。

モデルマージング:LLM開発の新潮流

モデルマージングは、複数の事前学習済みモデルを組み合わせることで、低コストでLLMを開発する手法です。追加の訓練を必要としないため、コストを大幅に削減できます。しかし、現状のモデルマージングは、人間の直感とドメイン知識に大きく依存しているという問題があります。モデルの選択やマージの方法(レシピ)は、熟練したモデル開発者の経験と勘に頼っているのが実情なのです。

進化的アルゴリズム:自然選択に学ぶ最適化手法

進化的アルゴリズムは、自然選択の原理に着想を得た最適化手法の一種です。複数の候補解を持つ「個体群」を用意し、優れた個体を選択的に残して次世代に引き継ぐことを繰り返すことで、徐々に最適解に近づいていきます。近年、進化的アルゴリズムはニューラルアーキテクチャ探索(NAS)の分野で大きな成果を上げています。モデルマージングに進化的アルゴリズムを適用する場合、事前学習済みのモデルを組み合わせるだけなので、訓練は不要です。つまり、進化的アルゴリズムとモデルマージングは非常に相性が良いと言えます。

研究では以下の結果がもたらされたことを示していました。

- 自動化されたモデル構成:我々は、多様なオープンソースモデルの最適な組み合わせを自動的に発見し、ユーザー指定の能力を持つ新しい基盤モデルを作成するための一般的な進化的方法であるEvolutionary Model Mergeを紹介する。このアプローチは、既存のオープンモデルの集合知を活用し、大規模なトレーニングデータや計算能力を必要とせずに、強力なモデルの作成を可能にする。

- 異分野マージ:我々の方法は、異分野のモデル(例えば、非英語言語と数学、非英語言語とビジョン)を従来の人間の設計戦略では達成できない可能性のある方法でマージする斬新な方法を発見できることを示す。

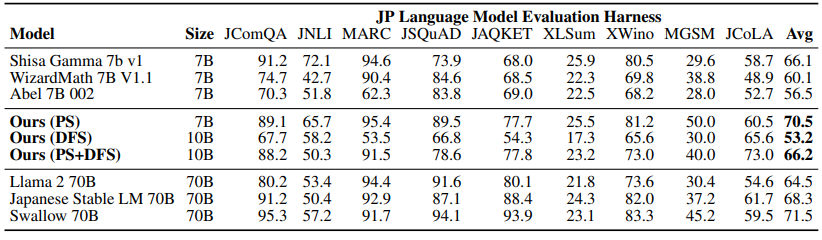

- 最先端のパフォーマンス:数学推論能力を持つ日本語LLMと日本語のVision-Language Model(VLM)を自動的に生成することで、我々の方法の有効性を示す。特筆すべきことに、両方のモデルとも、それらのタスクに明示的に最適化されていないにもかかわらず、さまざまなベンチマークで最先端の性能を達成している。

- 高い効率性と驚くべき一般化可能性:我々の7Bパラメータ言語モデルが、一部の以前の70Bパラメータ日本語LLMのパフォーマンスを上回っていることから、我々のアプローチの高い効率性と驚くべき一般化能力が明らかになった。我々は、このモデルが強力な汎用日本語LLMとして機能すると考えている。

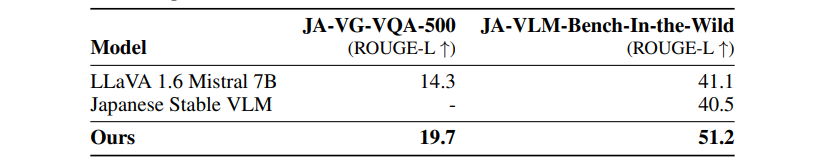

- 文化的に認識されたVLM:生成された日本語VLMは、国内で収集された日本語の画像-説明ペアのデータセットでテストされた際に、日本の文化に特化したコンテンツを処理する能力を実証し、トップの結果を達成した。

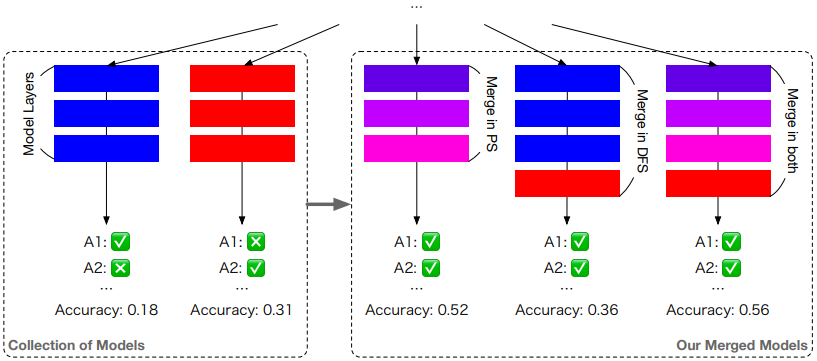

Evolutionary Model Merge:進化的モデルマージの提案

Evolutionary Model Mergeは、モデルマージングを「パラメータ空間」と「データフロー空間」の2つの側面から捉え、それぞれの空間で最適化を行う統一的なフレームワークです。パラメータ空間では、TIES-MergingとDAREという2つの手法を用いて、複数のモデルの重みを最適な割合で組み合わせます。一方、データフロー空間では、トークンの推論パスそのものを最適化するユニークなアプローチを取ります。さらに、パラメータ空間とデータフロー空間を組み合わせたハイブリッドな最適化も可能です。

日本語数学LLMの進化的マージ

日本語数学LLMは、日本語LLMと英語の数学LLMを進化的にマージすることで生成されます。shisa-gamma-7b-v1、WizardMath-7B-V1.1、Abel-7B-002の3つのモデルを使用し、MGSMというマルチリンガルな数学問題データセットで評価しました。日本語数学LLMは、MGSMデータセットにおいて非常に高い精度を達成しました。特に、パラメータ数が既存の大規模日本語LLMを大幅に下回るにも関わらず、それらを上回る性能を示したことは特筆すべき結果です。

日本語VLMの進化的マージ

日本語VLMは、shisa-gamma-7b-v1(日本語LLM)とLLaVA-1.6-Mistral-7B(英語VLM)を進化的にマージすることで生成されました。日本の文化に特化したオリジナルのベンチマークで評価した結果、生成された日本語VLMは非常に高いROUGEスコアを記録しました。LLaVAや日本語の事前学習済みVLMを大幅に上回る結果となっており、日本文化特有のコンテンツ理解力の高さが実証されました。

考察と展望

本研究の成果は、進化的モデルマージの有効性を強く示唆するものです。人手を介さず、自動的に高性能なモデルを生成できることが実証されました。さらに、モデル開発のコスト削減と効率化にも大きく寄与することが期待できます。ただし、進化的モデルマージにも課題はあります。例えば、ソースとなるモデル群をどのように選ぶかは、現状では人間が決める必要があります。この点については、モデル選択自体も進化的アルゴリズムで最適化できる可能性があります。また、多様性の高いモデル群を生成することも重要な課題です。

まとめ

Evolutionary Model Mergeは、進化的アルゴリズムを用いてモデルマージングを自動化する革新的な手法です。日本語数学LLMと日本語VLMの開発事例から、その有効性が実証されました。特に、日本語数学LLMが、パラメータ数を大幅に抑えながら既存の大規模モデルを上回る性能を達成したことは、大きな意義があります。また、日本語VLMが日本文化に特化したベンチマークで高い性能を示したことは、進化的モデルマージの応用可能性の広さを示唆しています。

開発されたEvoLLM-JPとEvoVLM-JPは、オープンソース化によってコミュニティに貢献してくれています。これをうまく利用して、よりよいLLMの開発が進めば本当に映画のような世界がやってくるかもしれませんね。

コメント